Copyright

© 2000-2015

LHERBAUDIERE

5 pages à l'impression

version

initiale 2002

dernière

mise à jour

22 mars 2013

22 mars 2013

|

Copyright |

5 pages à l'impression |

version

initiale 2002 |

||

| dernière

mise à jour 22 mars 2013 |

LES TENDANCES TECHNOLOGIQUES

première partie (1/8): idées et microcapteurs

| les

facteurs du développement |

||||

| un

digest |

||||

| l'histoire

et ses conséquences |

||||

| une collection d'icônes pour visiter tout le site | ||||

- En raison, d'une part, de l'utilisation de l'affichage numérique qui autorise une résolution croissante et, d'autre part, des possibilités de traitement du signal permettant l'exploitation beaucoup plus fine des données, ce qui génère des besoins nouveaux (ou permet enfin la satisfaction de besoins non satisfaits jusqu'alors) en terme de mesure de qualité, on doit en particulier augmenter la précision, la finesse des capteurs et leur interchangeabilité.

- Pour cela, on utilise les retombées des progrès de la physique du solide et de la chimie, en particulier dans le domaine des matériaux nouveaux qu'on appelle de plus en plus matériaux intelligents, d'abord de type alliages particuliers, puis matériaux organiques à propriétés mécaniques particulières (PVF2, "plastics electronics" ou nanotubes de carbone par ex.) et enfin biomatériaux micro usinables. Rappelons en effet que les fondements de la physique du solide et de la chimie du solide modernes datent essentiellement du début du 20ème siècle et tout particulièrement des années 30, cependant la majeure partie des assertions des grands savants de l'époque étaient théoriques et ne pouvaient être vérifiées faute de moyens technologiques appropriés. Dans les années 50-60, nombre de physiciens commencèrent à valider (ou invalider) ces théories, et ce ne sont que dans les années 70 et au delà que l'on put véritablement exploiter dans des applications nouvelles les résultats de ces multiples travaux de validation, d'abord en microélectronique, puis dans de nombreux autres domaines scientifiques ou pratiques.

- On développe ainsi de nouveaux principes de capteurs par emploi des technologies couches minces (voir les propriétés des couches minces) ou couches épaisses et d'une façon générale des techniques de la microélectronique et de l'optronique assurant outre de meilleures performances métrologiques, un progrès dans la miniaturisation et souvent la réduction de consommation et des temps de réponse.

- On emploie la microinformatique en utilisant toutes les ressources modernes du traitement du signal dans le domaine temporel ou fréquentiel, ainsi que des notions récentes telles la logique floue ou les réseaux de neurones, le tout associé à la disponibilité de mémoires numériques à bas coût et de capacité gigantesque dans un volume très réduit.

- Pour concevoir de nouveaux capteurs on n'hésite plus à investir dans la CAO, soit pour la conception du circuit - capteur, soit pour la modélisation et la simulation préalables.

- De nouveaux domaines d'investigation scientifique ou de développement technologique créent de nouveaux besoins en particulier en médecine, en protection de l'environnement, pour l'automobile ainsi que pour la biochimie et la chimie organique fine.

- Le domaine de la microélectronique et des nanotechnologies nécessite, pour son propre développement, des moyens de contrôle de plus en plus sophistiqués qui font de plus en plus appel à l'optique et l'imagerie pour l'analyse de surface des composants (analyse en 3-D).

- L'implémentation toujours plus grande de réseaux industriels impose le (ou s'accompagne du) développement de "capteurs intelligents " (et maintenant de systèmes intelligents) pour lesquels l'interopérabilité et la maintenabilité sont poussées.

- La mondialisation via internet s'accompagne d'une possibilité nouvelle, celle de téléchargement directement à partir du site d'un constructeur des nouvelles caractéristiques d'un système dont le logiciel de gestion vient, par exemple, d'être amélioré. Ce qui est vrai pour le système d'exploitation de votre ordinateur qui se met à jour sans que vous n'interveniez est dorénavant tout aussi possible pour les microsystèmes industriels et l'on peut même parfois réétalonner un ensemble à distance (entre les USA et l'Australie par ex.)

- Enfin la tendance à coupler dans un même microsystème exploitant les nanotechnologies à la fois l'aspect microélectronique et l'aspect micromécanique voire microoptique a donné naissance à une nouvelle discipline celle des "MEMS" (micro electro mechanical systems) et MOEMS (micro-opto- electro-mechanical systems, c'est à dire de nanosystèmes 3-D, dont le développement ouvre des perspectives nouvelles vers des applications impensables, voire même pas imaginées, il y a seulement un ou deux ans.

Nous aurions pu procéder à un découpage par fonctionnalité du capteur, mais comme notre exposé ne peut être exhaustif, nous pensons que le choix retenu est préférable. Pour chacun des principes nous présenterons quelques exemples typiques de réalisation dans divers domaines d'application. Par ailleurs, d'autres exemples pourront être trouvés dans les chapitres ultérieurs traitant spécifiquement d'une catégorie de capteurs ou d'une famille spécifique d'applications.les capteurs silicium micro-usinés, et leurs dérivés à base de substrats de verres spéciaux ou de céramiques qui constituent, historiquement, les premières applications des nanotechnologies.

les matériaux polymères et leurs applications en micro-usinage.

les capteurs dont l'élément sensible est une couche mince sur substrat varié, cette couche pouvant être obtenue via les technologies propres à la microélectronique, ou, ce qui est plus récent encore, selon des procédés microchimiques qui vont avoir des conséquences très importantes en particulier (mais pas exclusivement) dans le domaine de l'analyse biomédicale.

les capteurs à couches épaisses, très faible coût, grand public et développable à l'échelle semi-artisanale.

les capteurs usant de fibre optique comme média de transmission et/ou de mesure.

les capteurs micro-usinés à optique intégrée, dernier avatar des nanotechnologies.

quelques recherches ou applications de type multicapteur succéderont au chapitre sur les capteurs dit intelligents.

enfin nous parlerons un peu des micro-actionneurs relevant des mêmes nanotechnologies même si cela semble un peu déplacé dans un cours sur les capteurs.

2.1 microcapteurs intégrés et technologies associéesL'exploitation massive des techniques de la microélectronique permet de développer sur une puce de silicium de nouveaux capteurs de très faibles dimensions, et plusieurs capteurs sur un même wafer, et parfois même plusieurs capteurs de type différents, ce qui constitue un pas important vers la production de masse à coût réduit et la reproductibilité des caractéristiques d'un capteur à l'autre. En outre cela permet l'intégration de nouvelles fonctionnalités, autrefois non gérées ou mises en oeuvre dans une circuiterie annexe.

L'idée novatrice des pionniers de cette "révolution" c'était de faire passer le domaine capteurs de l'artisanat à la production de masse, ce qui impliquait reproductibilité des caractéristiques, miniaturisation et diminution des coûts de fabrication. Deux voies ont été explorées, l'une relativement facile concernait des capteurs conçus réellement comme de vulgaires composants électroniques, et dont l'exemple type est le capteur de température intégré (voir chapitre capteurs de température), l'autre concernait des capteurs mécaniques nécessistant la mise en oeuvre d'un micro-usinage du silicium et le type en est le capteur de pression.

- d'une part, celle qui consiste à transformer les fonderies de silicium en sous traitants de petites entités dénommées "startup" ne possédant pas d'unité de fabrication, mais seulement des bureaux d'étude et des services commerciaux (exemple typique Maxim à ses débuts), et développant des composants très innovants, mais à marché limité (donc ne justifiant pas un investissement dans un centre de production dédié à ce seul composant). Notons ce paradoxe : l'industrie électronique est alors le seul domaine industriel où les sous-traitants sont des entreprises de taille infiniment plus importante que les donneurs d'ordre, à l'inverse par exemple du domaine automobile où les sous-traitants sont de petites entités à la merci du grand constructeur.

- et d'autre part, le développement de microcapteurs à base de silicium. C'est cette seconde voie qui nous intéresse ici.

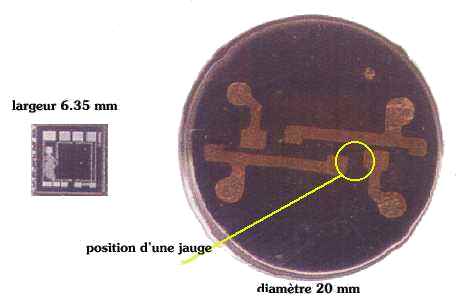

Deux options ont été envisagées : l'une d'elles, illustrée par les travaux du groupe Schlumberger en France, consistait à réaliser un wafer de 20mm de diamètre et ensuite à diffuser un pont de jauges dans ce wafer, lequel serait ultérieurement monté tel une membrane sur un corps d'épreuve cylindrique classique. Ce procédé fut rapidement abandonné car il n'apportait que peu d'avantages. Chaque capteur étant issu d'un wafer différent on ne bénéficiait pas de l'avantage de reproductibilité que procure un wafer générant après découpe n composants identiques car obtenus très exactement dans les mêmes conditions de préparation. En outre le coût du silicium utilisé eu égard à la taille de la membrane était élevé et enfin cette taille importante induisait des difficultés de connectique. En effet la membrane présentait une fréquence de résonance proche de celle des outils de soudure ultrasonique utilisés pour effectuer les connexions, ce qui rendait celles-ci particulièrement aléatoires.

- on supprime le collage des jauges, donc toutes les dérives inhérentes à l'emploi d'une colle qui peut comporter des microbulles, résiste mal à la température, vieillit sous l'effet des radiations UV et X

- on supprime le support isolant des jauges qui induit un retard de transmission des déformations et constitue un isolant thermique

- les jauges étant dorénavant intégrées dans la membrane en reflètent exactement les déformations et sont thermiquement dans une situation naturellement plus homogènes, réduisant les risques de dérive thermique différentielle (cf chap_2.htm).

- le coefficient de sensibilité du silicium est environ 50 fois plus élevé que celui des alliages de type constantan utilisés traditionnellement (mais le coefficient de température aussi malheureusement).

Vous vous intéressez aux capteurs, c'est bien, mais êtres vous environnementalement raisonnable, que savez-vous REELLEMENT des problèmes agricoles? Sortez de votre cocon et lisez les pages écologiques de ce site ça vous rendra plus intelligent. Ce n'est pas quand la planète sera foutue qu'il faudra dire je ne savais pas, on ne m'a jamais rien dit à l'école. aller plus loin

|