Copyright

© 2000-20145

LHERBAUDIERE

12 pages à l'impression

22 mars 2013

|

Copyright |

12 pages à l'impression |

version

initiale 2002 |

||

| dernière

mise à jour 22 mars 2013 |

CAPTEURS BIOMEDICAUX

troisième partie :

Instrumentation ambulatoire et imagerie

| un

domaine en expansion |

||||

| nucléaire

et sophistiqué |

||||

un

autre aspect de l'analyse |

||||

| une

usine à gaz! |

||||

| une collection d'icônes pour visiter tout le site | ||||

les contraintes

Les particularités de l'instrumentation médicale sont liées au fait que l'instrument sert toujours à acquérir des données directement au contact du patient ce qui implique diverses contraintes spécifiques :

en premier lieu des contraintes électriques, eu égard à l'impédance des tissus biologiques et afin de ne pas blesser le patient le courant et/ou les tensions appliquées ou risquant d'être appliquées par erreur ou en cas de dysfonctionnement de l'instrument sont strictement réglementées. pour les mêmes raisons les matériels doivent avoir des caractéristiques d'isolement et des tensions de claquage conformes. dès lors que le matériel est susceptible d'être confié à un patient, en mode ambulatoire ou non, celui-ci doit être d'une très grande fiabilité et ne doit pas pouvoir être modifié dans ses réglages par le patient. Il est absolument impératif qu'un procédé de sécurité (matériel ou logiciel) rende inopérant tout interrupteur ou toute commande dont le patient ne doit pas normalement dans le cadre de l'expérimentation clinique avoir à se servir. dans le même ordre d'idée un matériel confié à un patient ne doit pouvoir être bricolé par ce dernier (j'ai personnellement vu le résultat de tels bricolages sur des moniteurs d'ECG susceptibles d'être ouverts très aisément. Il est exceptionnel qu'un circuit CMOS puisse résister à un fer à souder d'électricien...). ce matériel doit être parfaitement étanche(c'est à dire résister à l'immersion dans une piscine ou une baignoire).

il doit comporter un dispositif d'alarme permettant d'identifier visuellement ou via un buzzer tout dysfonctionnement. L'idéal étant une combinaison alarme sonore de courte durée pour attirer l'attention et alarme visuelle explicite indiquant la nature du problème afin qu'un professionnel de santé, qui n'est pas par hypothèse un électronicien, puisse soit procéder à la remise en état de marche dans le cas d'anomalies simples (pile à changer, cable à rebrancher), soit faire intervenir un service de maintenance approprié. lorsque le matériel est réellement ambulatoire (c'est à dire destiné à être exploité hors milieu hospitalier) l'accent doit être mis en outre sur l'autonomie réelle de fonctionnement, c'est à dire la réduction de consommation. Pour cela tous les composants électroniques retenus devront être de type très basse consommation (CMOS) et on privilégiera en outre ceux disposant de fonctions de mise en veille, et on s'évertuera aussi à chasser le gaspi en n'alimentant que les éléments nécessaires à l'instant t et en ne procédant à des acquisitions et des stockages d'information qu'à bon escient. Ainsi à titre d'exemple il est parfaitement inutile de mesurer la température du patient toute les secondes. Une mesure toutes les cinq minutes suffit la plupart du temps et en général en alimentant le capteur durant guère plus de100ms on obtient une mesure stable dont on ne stockera le résultat que s'il est significativement différent de celui stocké précédemment. à chaque fois que cela sera possible on évaluera comparativement une solution hardware et une solution logicielle en terme de consommation d'énergie et de poids/compacité. En effet le meilleur compromis est celui qui permet de rendre le matériel réellement portable sans gène pour le patient et susceptible de fonctionner sans interruption pendant au moins la durée requise par l'exploration fonctionnelle en cours. cas de monitorage de longue durée à domicile

Lorsqu'il s'agit de suivre un patient pendant plusieurs semaines, voire plusieurs mois il est évident que l'on aura peu de chances de réussir à obtenir un compromis satisfaisant compacité/autonomie. Dans ce cas on devra envisager l'alimentation par batterie rechargeable, mais en prenant un certain nombre de précautions. premièrement il faut envisager deux jeux de batterie, l'un étant placé dans l'appareil et lui servant d'alimentation principale pendant que l'autre est en phase de recharge sur le secteur. On choisira des batteries en module étanche avec détrompeur afin d'éviter tout risque d'incident. Une alarme spécifique doit prévenir qu'il faut changer la batterie dans un délai raisonnable (15 minutes). Le changement de batterie implique un arrêt du processus d'enregistrement il est donc indispensable de prévoir, d'une part, son arrêt contrôlé (et non brutal) avant de changer de batterie et d'autre part, une sauvegarde des données enregistrées. La sauvegarde peut s'effectuer par le biais d'une microbatterie de sauvegarde des mémoires ou tout simplement par le choix de procédé de mémorisation ne nécessitant pas une alimentation de sauvegarde (mémoires EEPROM et dérivées). Pour gérer l'interruption du processus d'enregistrement et son redémarrage automatique on dispose de deux solutions. Soit un dispositif mécanique doit être basculé pour enlever la batterie (par exemple un capot de protection) et c'est lui qui simultanément enclenche le processus d'arrêt d'urgence et, après remplacement des batteries et remise en place du capot de protection, le processus inverse de redémarrage de l'enregistrement; soit le fait d'enlever la batterie est détecté par le circuit gérant l'alimentation de sauvegarde et celui-ci génère soit une interruption logicielle soit un processus électromécanique d'arrêt d'urgence. De nombreux dispositifs existent sur le marché pour gérer cela (voir le catalogue Maxim par exemple). Un exemple très récent (à suivre) d'un système sans contact

Lors de la Conférence IEEE, International Solid-State Circuits 2002 un nouveau système de suivi du rythme cardiaque et respiratoire, développé à Stanford dans le cadre d'un projet Lucent Technologies, a été présenté. Il devrait à terme permettre le monitorage de longue durée, en particulier des nourrissons ou des personnes âgées dont la peau ne supporte pas les électrodes classiques (brûlures). Il s'agit en fait d'un circuit très intégré comportant un radar Doppler à micro-onde rendant celui-ci à la fois peu coûteux, de faible taille et de faible poids et de ce fait le destinant à diverses applications courantes. Rappelons que l'effet Doppler est le changement de fréquence apparent qui se produit lorsqu'il y a déplacement entre la source et l'observation. Le capteur de signaux vitaux émet un simple signal qui est réfléchi par la poitrine du patient. Les mouvements respiratoire et cardiaque de celle-ci induisent un changement de la phase du signal réfléchi. Le récepteur détecte cette variation et génère alors un signal directement proportionnel à la position relative de la poitrinepar rapport à l'émetteur. Finalement les données sont filtrées et les rythmes respiratoire et cardiaque sont calculés. Pendant les essais ce système a fonctionné correctement à 50cm du patient et plus de 90% du temps. C'est effectivement le premier exemple de système radar miniaturisé à applications biomédicales. En raison de son ultraminiaturisation (moins de 4mm2 de silicium) cette technologie, basée sur des sous-circuits déjà exploités par ailleurs, semble promise à un bel avenir. Cependant il faut encore multiplier les expérimentations avant la commercialisation, en particulier dans divers environnements et pour diverses positions de patients. D'ores et déjà Medtronic et Biotronik s'intéressent à ce développement.

cas de système utilisant des capteurs susceptibles de dérives et vieillissement à long terme

Dans certains cas d'exploration on emploie des capteurs dont la durée de vie est limitée. Le cas le plus "à risque" est celui où la durée de vie représente une douzaine d'expérimentations ou une durée d'un mois environ. Le bon sens nous indique qu'il est nécessaire de vérifier le bon fonctionnement du capteur avant de confier le matériel au patient afin d'éviter de l'équiper d'un matériel globalement défectueux, mais aussi au retour du patient afin d'identifier une éventuelle dérive insuffisante pour être détectée comme "panne" par le matériel lui-même, mais suffisante pour fausser grandement les résultats et induire un mauvais diagnostic. L'expérience de l'auteur, tant en milieu hospitalier qu'en médecine libérale, montre que ces deux contrôles ne sont pas nécessairement effectués et que bien souvent on attend la panne totale pour changer le capteur défectueux.

Illustrons ce problème dans le cas de la pHmétrie oesophagienne. Précisons que de très nombreuses personnes souffrent de reflux gastro-oesophagien (souvent identifié par le patient par l'appellation erronée de brûlures d'estomac), le diagnostic implique un enregistrement du pH au niveau de l'oesophage (environ 4 cm au dessus du cardia, c'est à dire du sphincter qui normalement ferme l'estomac et interdit le reflux) pendant une durée allant de 3 heures à 24 heures. L'électrode de pH ingérée est donc soumise à l'action généralement corrosive (reflux acide) des pectines de l'estomac et cela se traduit par une perturbation de la porosité de la membrane de verre dont la résistivité augmente progressivement en environ un mois jusqu'à atteindre des valeurs supérieures à celle de l'étage d'entrée de l'amplificateur (pourtant de l'ordre de 1013W). La conséquence en est un affaiblissement relatif du signal, et donc une erreur de mesure, dont il résulte une erreur du calcul statistique effectué sur l'enregistrement et une sous évaluation de l'importance du reflux du patient concerné, et donc,in fine, une erreur de diagnostic.

Comment éviter cela? La réponse est très simple : il suffit, dans le logiciel interne au pHmètre enregistreur, d'incorporer des sous programmes de tests de la validité des électrodes avant le lancement de l'enregistrement automatique et après son arrêt. Ce test consiste à placer l'électrode dans une solution tampon à pH 9.4 et enregistrer le temps mis par l'électrode pour atteindre un état stationnaire : si ce temps dépasse 20 s l'électrode doit être rejetée (et le programme refuse d'aller plus loin tant qu'elle n'a pas été remplacée), sinon on la place dans une seconde solution tampon à pH inférieur à 7 et grâce aux deux mesures effectuées le logiciel de gestion peut corriger une éventuelle dérive de pente ou de zéro de l'ensemble de l'appareil dans la mesure où elle ne dépasse pas un certain seuil, auquel cas l'électrode est réputée défaillante. Mais cela ne suffit pas à garantir que l'opérateur exécutera ces sous programmes. On est donc amené à concevoir un programme principal dont les étapes s'enchainent impérativement selon un ordre immuable et ne peuvent être omises volontairement ou non.

![]() Ainsi l'enregistrement ne pouvant démarrer si l'on n'a pas contrôlé,

en respectant une procédure stricte, la validité de l'électrode,

ce contrôle sera exécuté.

Ainsi l'enregistrement ne pouvant démarrer si l'on n'a pas contrôlé,

en respectant une procédure stricte, la validité de l'électrode,

ce contrôle sera exécuté.

De même en fin d'exploration les résultats ne pourront être extraits de la machine tant que le contrôle de continuité de la validité de l'électrode n'aura été réalisé. Ce procédé a été mis en oeuvre sur le pHmètre développé au CRITT-GBM/INSA-Rouen et donne entière satisfaction depuis plus de vingt cinq ans aux nombreux utilisateurs européens tant en milieu hospitalier que chez les gastroentérologues de ville.

Fig. organigramme linéaire garantissant l'exécution de toutes les étapesPour en savoir plus sur la pHmétrie voir le chapitre chap_c4.htm

ergonomie et sécurité

Un outil d'aide au diagnostic exploité en milieu hospitalier comportera le plus souvent une interface vers un microordinateur et pratiquement de plus en plus souvent cet outil sera intégralement piloté par le biais du système informatique. Cela implique quelques remarques spécifiques au domaine médical. On a déjà indiqué plus haut toute l'importance de la prise en compte du patient et de ses handicaps éventuels dans la conception de l'outil. Il va de soi que l'informatique de gestion devra effectivement être conçue en tenant compte de cette exigence. Et nous insistons tout particulièrement sur le point suivant : lorsque l'opérateur est devant l'écran, c'est à dire dans un monde virtuel, il ne regarde pas le monde réel et ainsi il pourrait d'un clic de souris malencontreux déclencher dans le monde réel une action préjudiciable au patient. Il est donc absolument indispensable que le concepteur réfléchisse avec beaucoup de soin aux conséquences pratiques pour le patient d'une erreur de manipulation informatique. En outre ainsi qu'on l'a déjà mentionné le personnel hospitalier n'a généralement aucune formation en physique pratique et n'a pas nécessairement conscience des risques résultant de dysfonctionnements qu'il s'agisse de dysfonctionnements du type panne ou de dysfonctionnements liés à une fausse manoeuvre. Dans un laboratoire d'électronique un cable débranché est rapidement identifié et ne conduit généralement pas à un incident grave, à l'inverse en milieu hospitalier il y a fort à parier que l'identification de cet incident ne sera pas immédiate et qu'elle pourrait conduire à des incidents sérieux, on devra donc dans le matériel médical apporter un soin tout particulier à l'architecture permettant de réduire au maximum ce type de risques.

Enfin si l'on veut qu'un outil d'aide au diagnostic soit effectivement exploité en routine on devra en outre soigner l'ergonomie du logiciel auquel les personnels soignants sont très sensibles. En particulier il sera judicieux de permettre à l'opérateur de s'approprier ledit logiciel en lui laissant l'initiative de modifier à sa guise certains éléments de présentation. Ainsi sans lui donner la possibilité de modifier fondamentalement le programme, ce qui serait préjudiciable, on lui laissera le choix des couleurs de fond d'écran, du type de police de caractères, éventuellement de la position de certains boutons et de quelques éléments d'ergonomie lui permettant de personnaliser son outil. En outre on essaiera, dans la mesure du possible, de permettre à la demande la suppression de certains messages d'aide utiles lors de la prise en main du logiciel mais devenus inutiles, voire énervants, dès lors que l'opérateur maîtrise parfaitement l'outil, c'est une remarque certes non spécifique au domaine médical mais d'autant plus justifiée que les conditions expérimentales hospitalières sont le plus souvent stressantes tant pour le patient que pour le personnel (et les réductions de personnel hospitalier en France ne peuvent qu'augmenter ce stress et donc l'importance de cette remarque).

La dernière remarque concerne le dossier médical : celui-ci doit rester confidentiel (c'est à dire accessible seulement au personnel habilité et dans un proche avenir aussi au patient sous une forme exclusivement papier). En conséquence on veillera à introduire dans la partie acquisition concernant l'état-civil et les paramètres spécifiques du patient un élément de cryptographie interdisant à quiconque de récupérer par simple coupé-collé ou copie de fichier les éléments d'information confidentiels.

L'imagerie devient un mode privilégié d'aide au diagnostic en médecine depuis que certains outils permettent de visualiser dans une certaine mesure l'intérieur du corps humain. Il n'est pas dans notre propos de faire le tour des diverses techniques d'imagerie, mais seulement d'illustrer par quelques exemples la complexité des techniques généralement mises en oeuvre pour acquérir une information multidimensionnelle, puis pour en extraire ou reconstruire une image bi ou tridimensionnelle susceptible d'apporter au praticien une information spécifique d'un type de pathologie. On va prendre deux exemples très différents : la tomographie par caméra à positons et l'analyse dermatologique des lésions naeviques au moyen de diapositives (ou photos numériques) couleurs.

LA TOMOGRAPHIE D'EMISSION MONOPHOTONIQUE

Depuis quelques années, l'analyse du cerveau et du cœur en trois dimensions a pris une importance considérable. En imagerie cérébrale, les principales difficultés tiennent essentiellement à la complexité des structures et de leur fonctionnement. Le cœur, quant à lui, possède une structure morphologique plus simple. L'observation de certaines fonctions physiologiques de ces organes, en particulier la fonction de perfusion sanguine, est devenue possible à l'aide de la Tomographie d'Emission Monophotonique TEMP ou SPECT (Single-Photon Emission Computed Tomography) ou de la tomographie d'émission à positons PET (Positon Emission Tomography). La tomographie d'émission monophotonique ou la tomographie à positons diffèrent fondamentalement des autres modalités d'imagerie. Ainsi, alors que la technique d'imagerie par résonance magnétique (IRM) produit des images de structures anatomiques observées, l'imagerie SPECT ou PET produit (ou est censée produire) une cartographie des fonctions physiologiques.

principe

La tomographie

est l'une des techniques classiques de ce qu'on appelle la médecine nucléaire,

c'est à dire l'utilisation d'un rayonnement  le plus souvent produit par un radio-isotope dont l'absorption sélective

par les organes du patient va permettre à partir de l'analyse du rayonnement

émis de reconstruire une image à deux puis trois dimensions de

l'organe du patient. Le choix d'un isotope émettant des rayons

le plus souvent produit par un radio-isotope dont l'absorption sélective

par les organes du patient va permettre à partir de l'analyse du rayonnement

émis de reconstruire une image à deux puis trois dimensions de

l'organe du patient. Le choix d'un isotope émettant des rayons  se justifie par le fait que seuls ceux-ci sont susceptibles d'avoir un parcours

suffisamment long pour sortir du corps du patient et atteindre le détecteur.

se justifie par le fait que seuls ceux-ci sont susceptibles d'avoir un parcours

suffisamment long pour sortir du corps du patient et atteindre le détecteur.

En tomographie,

les images utilisées pour l'interprétation, sont construites à partir du signal

d'absorption d'un capteur ( caméra) sensible aux

radiations (photons

caméra) sensible aux

radiations (photons  ) d'un radio-isotope (typiquement

99Tc, 125I ou 131I) injecté préalablement au

patient. Précisons que le technétium est un radio-isotope très

original. En effet c'est un élément naturel qui a disparu de notre

planète car il n'existait que sous trois isotopes instables, ayant des

périodes certes longues, mais suffisamment courtes vis à vis de

l'âge de l'univers pour que ce matériau ait pratiquement disparu

sur terre. On sait le produire artificiellement, c'est d'ailleurs un déchet

nucléaire à longue période (215000 ans) dont on voudrait

bien se débarrasser, et il est intéressant en médecine

car il comporte un isomère nommé 99Tcm dont

le noyau possède la particularité d'exister dans un état

excité pendant une durée longue. En effet, alors qu'habituellement

un état excité du noyau cesse en quelques millisecondes, cet isomère

garde son état pendant plusieurs heures. Il peut ainsi être employé

en médecine nucléaire et permettre un examen assez long. Il faut

effectivement se rappeller que l'isotope radioactif que l'on injecte au patient

doit avoir une durée de vie suffisante pour permettre l'examen mais suffisamment

courte pour ne pas provoquer de nuisance chez le patient, d'où l'intérêt

pour ce technétium dont la période est de 6heures.

) d'un radio-isotope (typiquement

99Tc, 125I ou 131I) injecté préalablement au

patient. Précisons que le technétium est un radio-isotope très

original. En effet c'est un élément naturel qui a disparu de notre

planète car il n'existait que sous trois isotopes instables, ayant des

périodes certes longues, mais suffisamment courtes vis à vis de

l'âge de l'univers pour que ce matériau ait pratiquement disparu

sur terre. On sait le produire artificiellement, c'est d'ailleurs un déchet

nucléaire à longue période (215000 ans) dont on voudrait

bien se débarrasser, et il est intéressant en médecine

car il comporte un isomère nommé 99Tcm dont

le noyau possède la particularité d'exister dans un état

excité pendant une durée longue. En effet, alors qu'habituellement

un état excité du noyau cesse en quelques millisecondes, cet isomère

garde son état pendant plusieurs heures. Il peut ainsi être employé

en médecine nucléaire et permettre un examen assez long. Il faut

effectivement se rappeller que l'isotope radioactif que l'on injecte au patient

doit avoir une durée de vie suffisante pour permettre l'examen mais suffisamment

courte pour ne pas provoquer de nuisance chez le patient, d'où l'intérêt

pour ce technétium dont la période est de 6heures.

Par ailleurs cet isotope doit être préparé juste avant son emploi selon un processus d'extraction chimique, mis en suspension dans un liquide neutre, introduit dans une seringue en quantité rigoureusement définie, puis la seringue doit être contrôlée sur le plan de son activité dans un activimètre à puits (c'est à dire une chambre blindée en plomb dans laquelle un détecteur calibré de type scintillateur va permettre de déterminer l'activité de l'échantillon, soit le nombre de photons

émis par seconde) et ce n'est qu'alors que la quantité calibrée pourra être injectée au patient.

La figure montre le principe du système.

Fig. Principe

d'acquisition des images SPECT.

La  -caméra

est constituée d'un détecteur à scintillation en NaI le

plus souvent, associé à un photomultiplicateur et un collimateur.

En général, le détecteur

est constitué d'un ensemble de matrices de détecteurs élémentaires sensibles

aux rayons

-caméra

est constituée d'un détecteur à scintillation en NaI le

plus souvent, associé à un photomultiplicateur et un collimateur.

En général, le détecteur

est constitué d'un ensemble de matrices de détecteurs élémentaires sensibles

aux rayons  et disposés de manière circulaire autour

du patient. Chaque détecteur élémentaire doit avoir de bonnes propriétés d'absorption

des rayons

et disposés de manière circulaire autour

du patient. Chaque détecteur élémentaire doit avoir de bonnes propriétés d'absorption

des rayons  . Typiquement, il s'agit d'un cristal

d'iodure de sodium dopé au thallium d'épaisseur comprise entre 0,95cm et 1,25cm.

Quand un rayon

. Typiquement, il s'agit d'un cristal

d'iodure de sodium dopé au thallium d'épaisseur comprise entre 0,95cm et 1,25cm.

Quand un rayon  frappe le cristal, un électron rapide

est généré. La décélération de cet électron, provoquée par les interactions

avec le cristal, donne naissance à un phénomène

de scintillation. Cette production d'une radiation dans le spectre visible

est captée par un tube photomultiplicateur et convertie en une impulsion électrique.

Le collimateur, ainsi qu'il est montré sur la figure est destiné

à filtrer les photons en ne permettant le passage que de ceux qui proviennent

de la bonne direction, c'est à dire de l'endroit correspondant de l'organe

examiné.

frappe le cristal, un électron rapide

est généré. La décélération de cet électron, provoquée par les interactions

avec le cristal, donne naissance à un phénomène

de scintillation. Cette production d'une radiation dans le spectre visible

est captée par un tube photomultiplicateur et convertie en une impulsion électrique.

Le collimateur, ainsi qu'il est montré sur la figure est destiné

à filtrer les photons en ne permettant le passage que de ceux qui proviennent

de la bonne direction, c'est à dire de l'endroit correspondant de l'organe

examiné.

Le détecteur produit ainsi une cartographie de la distribution du radio-isotope à l'intérieur du corps humain selon différents angles de vue. Un algorithme de reconstruction s'appuie sur cette cartographie pour restituer, sous forme de coupes empilées, des vues particulières des distributions d'absorption ou de concentration du radio-isotope dans les structures anatomiques.

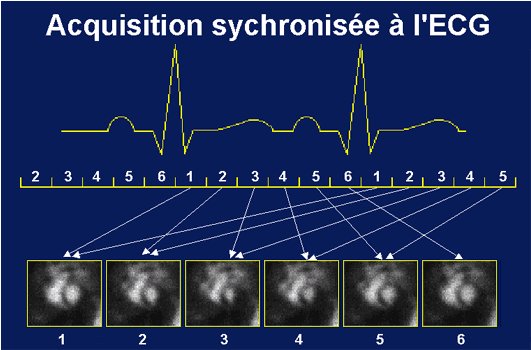

Notons que fréquemment l'acquisition est synchronisée sur le signal cardiaque du patient ce qui améliore la qualité de l'image obtenue. C'est évidemment tout particulièrement le cas lors d'examen du coeur ce qui permet alors de visualiser le coeur à diverses étapes du cycle cardiaque.

nous devons cette

image à A.Aurengo de l'Hôpital Pitié-Salpêtrière

Il est à noter

que des effets indésirables altèrent la détermination correcte de la distribution

initiale du radio-isotope. Il s'agit de l'effet Compton ou interaction photon-électron

induisant une perte d'énergie du photon  incident

et altérant ainsi sa trajectoire originale : dans ce cas la position

apparente du photon détecté sera donc différente de sa position anatomique initiale.

Des corrections sont apportées pour atténuer ces effets indésirables. La résolution

spatiale obtenue sur des images dans ces technologies est typiquement de l'ordre

de 10 à 20 mm en SPECT et de 4 à 6 mm pour le PET.

incident

et altérant ainsi sa trajectoire originale : dans ce cas la position

apparente du photon détecté sera donc différente de sa position anatomique initiale.

Des corrections sont apportées pour atténuer ces effets indésirables. La résolution

spatiale obtenue sur des images dans ces technologies est typiquement de l'ordre

de 10 à 20 mm en SPECT et de 4 à 6 mm pour le PET.

Fig. Outils d'acquisition d'images SPECT et PET.procédure expérimentale

Les acquisitions

TEMP ou SPECT, dont les appareils de prise de vues sont montrés ci-dessus, sont

réalisées une heure après l'injection intraveineuse de 1000MBq d'un traceur

de perfusion, le 99Tcm EthylCysteinate Dimère (ECD),

dans des conditions de calme visuel et auditif. Cette durée est jugée

suffisante pour assurer une répartition homogène du traceur dans

le sang et donc garantir la pertinence de l'image obtenue. Les images sont obtenues

via une  -caméra double tête (DST-XL, de chez SMVi)

équipée avec des collimateurs fan-beam. La tête des sujets est positionnée et

immobilisée dans une têtière pendant la durée de l'examen. Pour

chaque acquisition, 64 projections de 60 secondes sont obtenues sur 360° (32

projections par tête) avec une matrice de projections de 128x128 pixels. Les

données TEMP sont reconstruites en utilisant la méthode de la rétroprojection

des projections filtrées avec un filtre d'apodisation de Hann (fréquence de

coupure kc=0,5 cycles/pixel) et un zoom de reconstruction de 2 (matrice 128x128x128,

taille du voxel : 1,7x1,7x1,7 mm). Il n'est pas réalisé de correction d'atténuation.

La résolution spatiale au niveau du centre de rotation dans l'air est de 7,4mm

(rayon de giration : 12,5 cm). Cette procédure d'acquisition est entièrement

validée [VER97] et expliquée graphiquement sur la figure.

-caméra double tête (DST-XL, de chez SMVi)

équipée avec des collimateurs fan-beam. La tête des sujets est positionnée et

immobilisée dans une têtière pendant la durée de l'examen. Pour

chaque acquisition, 64 projections de 60 secondes sont obtenues sur 360° (32

projections par tête) avec une matrice de projections de 128x128 pixels. Les

données TEMP sont reconstruites en utilisant la méthode de la rétroprojection

des projections filtrées avec un filtre d'apodisation de Hann (fréquence de

coupure kc=0,5 cycles/pixel) et un zoom de reconstruction de 2 (matrice 128x128x128,

taille du voxel : 1,7x1,7x1,7 mm). Il n'est pas réalisé de correction d'atténuation.

La résolution spatiale au niveau du centre de rotation dans l'air est de 7,4mm

(rayon de giration : 12,5 cm). Cette procédure d'acquisition est entièrement

validée [VER97] et expliquée graphiquement sur la figure.

Fig. De gauche à droite : Principe d'acquisition d'images SPECT, PET et TDMexemples d'images reconstruites

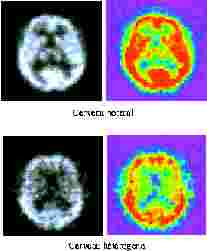

Après acquisition,

les images sont reconstruites par projection et constituées en une pile correspondant

à des coupes de l'organe (images 2D au format 64

par 64 pixels ou 128 par 128 pixels) La figure montre en haut à gauche une coupe

d'un cerveau "normal" et, en haut à droite, la même image obtenue après modification

de la Look Up Table ou LUT , opération qui a pour objet de transposer

l'image en niveaux de gris en une image en fausses couleurs visuellement plus

facile à interpréter pour le clinicien. Précisons que cette

transformation suppose que chaque niveau de gris de l'image initiale soit réellement

significatif, c'est à dire qu'entre l'émission de photons  et la reconstruction de cette image en niveaux de gris il n'y ait pas eu d'erreur

de conversion (non linéarité, dérive thermique, décalage

de zéro, erreur de pente ...).

et la reconstruction de cette image en niveaux de gris il n'y ait pas eu d'erreur

de conversion (non linéarité, dérive thermique, décalage

de zéro, erreur de pente ...).

En bas, la figure montre une coupe d'un cerveau "hétérogène" à gauche et la même image obtenue après modification de la LUT à droite. La zone rouge représente le cortex du patient. On peut voir que sur l'image du haut, elle est parfaitement définie et fait le tour complet de la boite crânienne, alors que sur l'image du bas, la zone rouge est coupée par endroit et on peut dire que le patient est hétérogène, ce qui est significatif d'une pathologie.

Fig. Images

SPECT de patients homogènes (en haut) et hétérogène (en bas).

La figure suivante montre le résultat de cette technique appliquée au coeur : en haut une coupe d'un cœur "normal" et en bas celle d'un cœur "hétérogène".

Fig. Coupes

SPECT de cœur homogène (en haut) et hétérogène (en bas).

Comme on peut le constater sur ces quatre coupes, deux de cerveau et deux de cœur, la notion d'hétérogénéité n'est pas forcement évidente à analyser. Pour le cerveau, l'hétérogénéité d'un patient peut dépendre de divers facteurs. Ainsi, il peut avoir un manque pur et simple d'une partie de cortex et l'on comprend mieux pourquoi l'image du cortex n'est pas entière, mais il peut aussi être atteint d'une maladie qui empêche l'écoulement du sang, donc du traceur dans le cortex, et il devient alors important de comprendre ce qui ce passe. Pour le cœur les problèmes sont analogues, soit une image est hétérogène à cause d'une absence ou du sous-développement d'une partie importante, soit en raison d'une pathologie affectant la circulation sanguine.

les problèmes en suspens

En outre, les docteurs Véra et Manrique au CHU de Rouen cherchent à mettre au point un index permettant de traduire l'évolution en terme d'hétérogénéité d'un patient pour compléter l'analyse visuelle, seul moyen dont on dispose actuellement. Nous n'irons pas au delà de cette présentation dont l'objet est seulement de montrer au lecteur les difficultés des procédures d'analyse d'image en médecine. Précisons cependant qu'une recherche est en cours pour définir un index qui serait capable de distinguer les deux séries de coupes précédentes en les classant de plus hétérogène à plus homogène. Cependant un tel index ne doit pas prendre en compte la taille de l'image et doit être insensible au bruit de l'image. Lorsque l'on regarde les images précédentes, on constate qu'elles sont composées d'un certain nombre de textures et c'est effectivement un axe directeur de cette classification que de l'aborder en terme d'analyse de texture.

problème médical

Ce second exemple est très différent du précédent et concerne le problème de l'identification des mélanomes (cancer de la peau). Rappelons que l'exposition aux ultra-violets d'origine solaire produit diverses réactions pigmentaires dont le bronzage, mais aussi parfois et tout particulièrement sur des sujets jeunes et non protégés des lésions mélanocytaires d'une extrème dangerosité en raison de leur propension à induire des métastases via le système lymphatique. Il convient donc de dépister au plus vite un grain de beauté évoluant anormalement. La difficulté pour le dermatologue provient du fait qu'il convient le plus souvent de comparer une situation nouvelle avec une situation antérieure dont la mémorisation n'a pu être effectuée que par le biais d'une photographie réalisée dans des conditions de prise de vue non standardisées sur un patient qui par essence n'est pas exactement le même à 3 ou 6 mois d'intervalle. En outre d'un patient à un autre les peaux sont très diverses et les lésions naeviques bénignes ou malignes peuvent prendre des configurations très diverses.

...

... ...

... ...

...

Fig. naevus atypique..........naevus bénin.....................tumeur noire..........................mélanome S.S.M.

Les différents exemples ci-dessus montrent la difficulté majeure de l'identification : le naevus atypique de gauche est bénin alors que le mélanome de droite est un cancer et pourtant leurs aspects visuels ne sont pas très différents, par contre il n'y a aucune difficulté à identifier un naevus normal ou une tumeur noire (la plus grave)

problème d'acquisition

Dans ce contexte quel peut-être l'apport des techniques de traitement d'images? Alors que dans le cas de la tomographie l'instrument était parfaitement identifié et son rôle dans l'obtention de l'image absolument essentiel à la fois au niveau de l'émission photonique que de l'instrumentation d'acquisition, ici l'appareil photo et les techniques de développement de la diapositive qui servira de support d'archivage ne sont pas standardisés. D'un dermatologue de ville à un autre, les techniques photographiques sont très diverses et constituent un facteur de disparité des images non maitrisable et source de difficultés multiples.

La figure ci-dessous illustre ce premier problème en montrant le même grain de beauté, photographié avec le même appareil, mais dans des conditions de prises de vue différentes.(noter que les divers traitements de compression subis par ces photos pour les amener jusqu'à votre PC avec des temps de téléchargement raisonnables les ont sensiblement altérées en faisant apparaitre des textures géométriques non présentes sur les diapos originales, mais les colorations sont globalement correctes)

L'exploitation automatisée de telles images va donc impliquer un traitement informatique de correction de la couleur. L'idée repose sur le fait que la lésion est entourée d'une zone de peau saine. Ainsi on va identifier une zone de peau saine et faire un recalage photométrique en remplaçant cette peau saine par une peau étalon qui va servir de référence colorimétrique, on pourra ainsi corriger l'ensemble de l'image et ainsi obtenir des lésions colorimétriquement comparables.

segmentation d'image

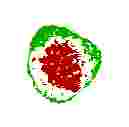

La phase opératoire suivante consiste à détecter les contours de la lésion. Différents procédés sont utilisés en raison de l'existence fréquente de zones floues à l'interface peau saine-lésion. On constate que sur une lésion bénigne ce contour est toujours régulier, alors qu'en présence d'un mélanome le contour est irrégulier et possède des encoches ainsi qu'on le voit sur les deux exemples ci-dessous.

...

Fig. contours régulier (bénin) et irrégulier (malin)classification

Un autre critère visuel a consisté à séparer les 3 composantes RVB de l'image, travailler sur l'une d'elles et ensuite seuiller astucieusement les niveaux d'intensité et ainsi à faire apparaître un pseudo relief coloré ensuite en fausses couleurs. On peut ainsi examiner une douzaine de paramètres calculables faisant intervenir soit la géométrie soit la colorimétrie. Un exemple de résultat graphique est présenté ci-dessous montrant pour un naevus bénin un aspect sensiblement de cible tandis que pour un mélanome malin on obtient quelque chose de très irrégulier. Cependant il s'agit d'un résultat qualitatif.

...

...

Fig. résultat

d'un traitement sophistiqué révélant un aspect de cible

(bénin) ou très irrégulier (malin).

De très nombreux travaux sont en cours pour examiner le degré de confiance que l'on peut avoir dans le résultat (malin ou non) du traitement automatique reposant sur l'exploitation d'une combinaison de critères colorimétriques ou géométriques, en vue d'identifier la combinaison la plus pertinente et accessoirement la moins gourmande en temps de calcul. En effet à terme il est clair que chaque dermatologue possèdera un appareil photo numérique et qu'il exploitera, en temps réel, l'image saisie pour établir son diagnostic, il est donc indispensable que le logiciel d'aide au diagnostic soit non seulement fiable, mais aussi rapide. En outre divers paramètres non inclus dans l'image mais cependant informatifs et d'importance parfois non négligeable dans l'établissement d'un diagnostic (antécédents, âge du patient, etc.) devront pouvoir être pris en compte.

![]() En conclusion nous insisterons sur la très grande

diversité des conditions de prise de vue ou d'acquisition

d'images qui constituent dans toutes les techniques d'imagerie médicale

la principale difficulté à surmonter avant de pouvoir envisager

une exploitation informatique pertinente. Ainsi dans toutes les techniques de

type scanner où l'image est une construction artificielle obtenue

point par point à partir d'un signal électrique il est évident

qu'une erreur de gain ou qu'un seuillage malencontreux (décalage de zéro

d'un ampli) peut conduire à des reconstructions d'images sensiblement

différentes et par suite à des interprétations totalement

erronées. Et j'ai, malheureusement, une trop grande expérience

de ce type d'anomalies, pour pouvoir considérer qu'il s'agit de risque

rarissime.

En conclusion nous insisterons sur la très grande

diversité des conditions de prise de vue ou d'acquisition

d'images qui constituent dans toutes les techniques d'imagerie médicale

la principale difficulté à surmonter avant de pouvoir envisager

une exploitation informatique pertinente. Ainsi dans toutes les techniques de

type scanner où l'image est une construction artificielle obtenue

point par point à partir d'un signal électrique il est évident

qu'une erreur de gain ou qu'un seuillage malencontreux (décalage de zéro

d'un ampli) peut conduire à des reconstructions d'images sensiblement

différentes et par suite à des interprétations totalement

erronées. Et j'ai, malheureusement, une trop grande expérience

de ce type d'anomalies, pour pouvoir considérer qu'il s'agit de risque

rarissime.

Les endoscopes sont utilisés en médecine, mais aussi dans diverses applications technologiques où une cavité ne peut être visualisée directement. Les principaux domaines d'application médicale sont la chirurgie, l'urologie, le neurochirurgie, la gastroentérologie, l'obstétrique, l'orthopédie, la médecine vétérinaire et dans l'industrie un endoscope sert à examiner des moteurs, des tuyaux, mais aussi des constructions architecturales voire à la protection de l'environnement.

Sur la figure ci-dessus on présente l'organisation d'un endoscope classique à fibre optique. L'image sera transmise par le coeur de la fibre tandis que la lumière destinée à éclairer la scène sera véhiculée via la gaine. L'ensemble du dispositif peut faire 500µm de diamètre et jusqu'à deux mètres et parfois plus de longueur. De plus en plus les utilisateurs souhaitent relier l'oculaire non à l'oeil de l'observateur mais à un système d'enregistrement et de visualisation informatisé, plus confortable pour l'observateur.

Cette exigence a conduit à une conception d'un nanosystème, schématisé sur la figure ci-dessous, dans lequel le système vidéo est intégré directement derrière la lentille et non au niveau de l'oculaire ce qui garantit une bien meilleure qualité d'image. Ceci a été rendu possible grâce à la miniaturisation des capteurs CCD et de leur électronique associée.

vidéo-endoscope

Cette micro-caméra est un microsystème complet avec micro-optique, micro-électronique et microcomposants mécaniques, elle convertit l'image en signal électrique transmis par un simple cable électrique. Le diamètre de l'endoscope dépend du module CCD. Les progrès de la miniaturisation permettent d'envisager en outre d'intégrer dans le micromodule d'autres fonctions comme l'imagerie par ultra-sons ou la tomographie.

H.Bauschke, D.Noll, A.Celler, " An EM algorithm for dynamic SPECT tomography ", 1994.

P.Vera, and al, "advantage of fan beam collimators for contrast recovery of hyperfixation in clinical SPECT. " IEEE Transactions on Nuclear Science, 1997, 44, pp 83-89.

A.R.Rao, "A taxonomy for texture description and identification ", Springer Series in Perception Engineering, Springer-Verlag, Heidelberg, 1990

O. Colot, P. Joly, K. Taouil, D. de Brucq, Ph. Lauret et M. Hubin,Analysis by means of image processing of benign and malignant melanocytic lesions, European Journal of Dermatology, 5, 1995, 441.

D. de Brucq, O. Colot, M. F. Mihout,Traitement numérique d'images en détection de mélanomes malins, Médecine & Hygiène, 54: 486-489, Mars 1996.

O. Colot, R. Devinoy, A. Sombo, D. de Brucq. A Colour Image Processing Method for Melanoma Detection. Lecture Notes in Computer Science, 1496. Eds: W. M. Wells, A. Colchester, S. Delp. Springer- Verlag, 1998, pp.562-569.

C. Level, O. Colot et al., Comparaison de plusieurs méthodes de diagnostic des tumeurs de la peau. Ann. Dermatol. Vénéreol., 1999, p.77.

P. Vannoorenberghe, O. Colot et D. de Brucq, Dempster-Shafer's theory as an aid to color information processing - Application to melanoma detection in dermatology. International Conference on Image Analysis and Processing ICIAP'99.

A. D. Droitcour & al., New Technology Monitors Vital Signs from Half a Meter Away, International Solid-State Circuits Conference, ISSCC 2002.

K.M. Irion, Endoscopes, Potential for Microsystem Technology, MST News, Special Report, 2005-02, p.24.

http://www.la radioactivite.com/medecin.htm