Copyright

© 2000-2015

LHERBAUDIERE

4 pages à l'impression

version

initiale 2002

dernière

mise à jour

22 mars 2013

22 mars 2013

|

Copyright |

4 pages à l'impression |

version

initiale 2002 |

||

| dernière

mise à jour 22 mars 2013 |

|

le

capteur interligne |

||||

|

les

notions basiques |

||||

| une collection d'icônes pour visiter tout le site | ||||

Nous allons ci-dessous introduire quelques notions élémentaires de traitement d'image, afin de permettre au lecteur de prendre conscience de l'importance potentielle des sources de bruit et de la nécessité de les réduire au mieux à la source.problèmes d'imagerie

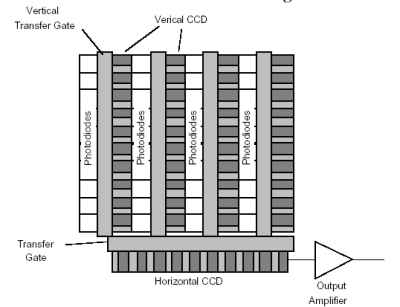

- Il va de soi que le transfert doit être effectif à chaque coup d'horloge et que la fréquence doit être élevée si l'on veut pouvoir afficher ensuite une image en temps quasi réel sur un écran d'ordinateur. Si l'efficacité du transfert est insuffisante, c'est à dire si la totalité de la charge n'est pas transmise dans le temps d'horloge on va constater un décalage sur l'image reconstituée. On admet généralement que, pour un imageur de type télé, il faut une inefficacité de transmission inférieure à 10-4.

- Il est aussi évident que ce phénomène n'est pas constant, car il y aura une plus grande probabilité de ne pas avoir transféré la totalité des charges pour un point brillant (auquel correspond un grand nombre de photons, donc de charges à transférer) que pour un point sombre. Le phénomène conduit donc à une distorsion. Cependant ce n'est pas simple à quantifier, car lorsqu'il y a un faible niveau de charges il y a une interférence possible avec des états d'interface qui résultent de l'imperfection structurelle du système et dont l'importance relative est évidemment plus grande lorsqu'on transfère une faible quantité de charges. En outre, il ne faut pas non plus oublier que les porteurs de charge de même signe ont tendance à se répulser ce qui augmente le bruit.

- D'autres sources de bruit sont présentes : instabilité de l'horloge, bruit d'origine thermique, et bruits associés aux circuits de lecture, et enfin le bruit limite résulte de l'arrivée même des photons qui est statistiquement aléatoire.

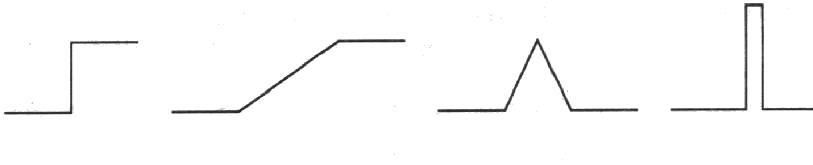

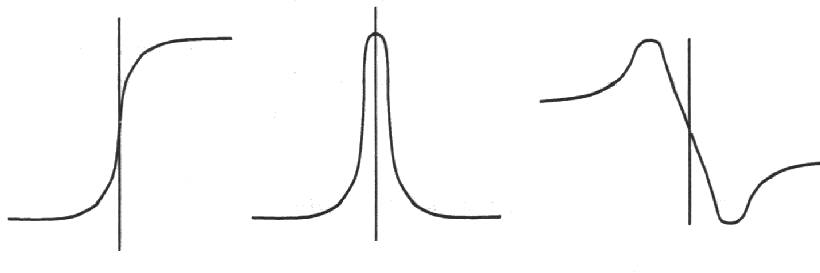

- Les conséquences sur les traitements d'image méritent d'être identifiées: Les principaux traitements effectués sur une image sont la segmentation et la détection des contours. Les distorsions signalées précédemment vont avoir pour principale conséquence de modifier aléatoirement l'intensité de certains points ce qui aura pour effet de modifier les contrastes et donc de réduire l'efficacité des opérateurs de traitements qui utilisent des méthodes basées sur les variations de contrastes dans une image pour séparer les zones d'intensité semblables et en délimiter les contours.

L'objectif fondamental de la vision par ordinateur, qui est un processus de traitement de l'information, est, à partir d'une entrée typiquement constituée d'une image ou d'une séquence d'images, de réaliser, via l'exploitation d'un algorithme plus ou moins complexe, une description de l'entrée en terme d'objets et derelations entre ces objets.Deux types de stratégies sont mises en œuvre: ascendantes ou descendantes. Dans le premier cas on tente de construire une représentation abstraite à partir de primitives. Au contraire, dans le second cas, on déduit à partir de l'ensemble des objets connus une description compatible avec les primitives extraites de l'image. Les connaissances mises en jeu sont de type physique, géométrique ou sémantique. L'un des grands problèmes de la reconnaissance est lié au fait que l'image est en deux dimensions et qu'elle représente le plus souvent une scène en 3D.

sur les capteurs optiques

|